在數據驅動決策的時代,傳統數據處理架構在應對海量、多源、實時數據時日益捉襟見肘。構建一個全新一代的、面向未來的分布式數據處理服務,已成為企業數字化轉型的核心工程。這并非簡單的技術堆砌,而是一場從理念到實踐的系統性革新。以下是從零開始打造這樣一個架構的路線圖與核心思考。

一、 奠基:明確目標與核心原則

在編寫第一行代碼之前,必須確立清晰的愿景與不可動搖的原則。

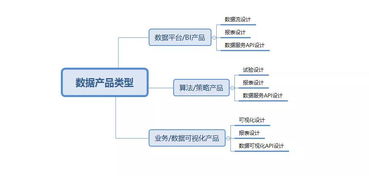

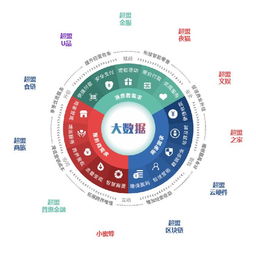

- 核心目標:新一代架構應旨在實現數據的實時化(低延遲處理)、智能化(內置AI能力)、平民化(降低使用門檻)與成本最優化(彈性伸縮,按需付費)。

- 設計原則:

- 云原生與彈性:深度擁抱容器化、微服務和聲明式API,實現資源的秒級彈性伸縮。

- 流批一體:統一流處理和批處理的計算模型與API,簡化開發運維,保障數據一致性。

- 存算分離:將存儲與計算資源解耦,實現獨立擴展,提升資源利用率和靈活性。

- 數據自治:內嵌數據治理、質量監控與血緣追蹤能力,確保數據可信、可管、可用。

- 多模與開放:支持關系、文檔、圖、時序等多種數據模型,并兼容主流開源生態(如Hadoop, Spark, Flink)。

二、 構建:分層架構與核心組件

一個穩健的架構通常自上而下分為五層:

- 統一接入與元數據層:

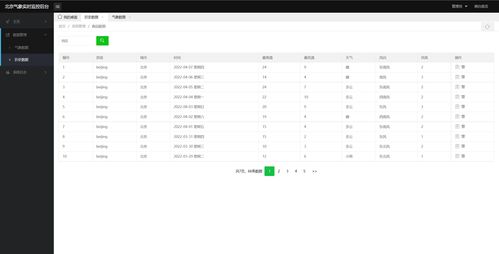

- 入口:提供統一的RESTful/gRPC API、SDK及SQL網關,屏蔽底層復雜性。

- 元數據中樞:構建強大的元數據管理系統,統一管理表結構、數據血緣、權限策略與任務調度信息,這是整個數據體系的“大腦”。

- 計算引擎層:

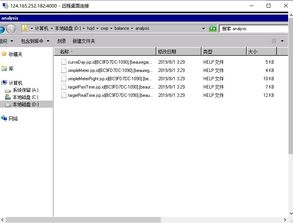

- 核心引擎:采用或深度定制如Apache Flink、Spark 3.x等流批一體引擎作為處理核心。

- 查詢引擎:集成Trino/Presto或ClickHouse等,提供交互式即席查詢能力。

- 任務編排:使用Apache DolphinScheduler或Airflow進行復雜工作流的可視化編排與調度。

- 存儲層:

- 對象存儲:以Amazon S3、Azure Blob或MinIO作為原始數據與計算結果的廉價、持久化存儲底座。

- 數據湖倉:基于Iceberg、Hudi或Delta Lake構建數據湖表格式,在對象存儲之上實現ACID事務、時空查詢等數據倉庫能力。

- 高速緩存:引入Alluxio或Redis作為熱數據緩存層,加速計算。

- 資源管理與調度層:

- 核心調度器:以Kubernetes為基石,統一管理和調度所有計算、服務容器,實現高可用與彈性。

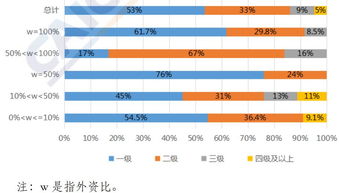

- 多租戶與資源隔離:在K8s Namespace和Quota基礎上,構建業務級的資源組與配額管理,保障關鍵任務。

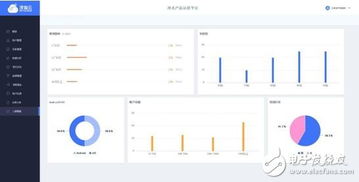

- 運維監控與治理層:

- 可觀測性:集成Prometheus、Grafana、ELK棧,對集群健康、任務性能、數據質量進行全方位監控與告警。

- 數據治理:集成數據目錄、質量規則引擎、敏感數據識別與脫敏工具,實現數據全生命周期治理。

- 安全:貫穿始終的認證(如Kerberos/OAuth)、授權(RBAC)、審計與網絡隔離。

三、 實施:關鍵路徑與挑戰應對

- 漸進式路徑:

- 階段一(MVP):基于云托管K8s和托管對象存儲,快速部署核心計算引擎(如Flink)和湖倉格式(如Iceberg),打通一條從數據接入到查詢的端到端流水線。

- 階段二(擴展):引入任務編排、統一元數據管理,完善多租戶與監控體系,支持更多業務團隊接入。

- 階段三(深化):集成機器學習和智能運維能力,實現成本分析與自動優化,構建完整的數據產品體驗。

- 核心挑戰與對策:

- 復雜性:通過提供高度封裝的服務化產品(Data as a Service)和自動化運維工具,降低用戶和運維人員的認知負擔。

- 成本控制:實施細粒度資源計量、自動化彈性策略(如基于隊列長度的自動擴縮容)和閑時資源回收。

- 數據一致性:依靠湖倉格式的事務保證和計算引擎的精確一次(Exactly-Once)處理語義來構建信任。

- 人才缺口:投資于平臺本身的易用性建設,并建立完善的內部培訓與文檔體系。

四、 演進:面向未來的持續迭代

新一代架構的生命力在于持續演進。關注Serverless化、智能化(AI for DataOps)、數據網格(Data Mesh)領域化自治等前沿趨勢,并思考將其融入架構。始終以“服務于業務的數據生產力平臺”為最終目標,讓數據基礎設施從成本中心轉變為創新引擎。

從0到1的旅程充滿挑戰,但通過清晰的藍圖、分步的實施以及對核心原則的堅持,構建一個能夠應對未來數據洪流、賦能業務創新的分布式數據處理架構,不僅是可行的,更將成為企業在數字競爭中最堅實的基石。